GPT-4의 아키텍쳐가 Mixture of Experts (MoE) 구조를 갖고 있다는 얘기가 퍼져 있었다. 여기 말대로 느슨한 (Loosely connected, 또는 Sparse) 한 전문가들의 연합으로 Monolithic 구조보다 더 나은, 더 효과적인 인공지능에 다가설 수 있을 것이라는 생각은 정말 오래 되었다. 내 대학원 당시에도 그랬다.

이는 지구에 있는 모든 고등 생명체의 지적 활동이 MoE 구조를 갖는 프로세서에 기반하는 사실에서도 감을 잡을 수 있었다.

문제는 늘, 어떤 전문가들이 어떤 경우에 필요하고, 이들을 어떻게 얻나 (개별 훈련, 함께 훈련)? 전문가들의 전문성/독립성 대비 compliance 특성을 어떻게 가져가야 하나? 이들을 어떻게 coordinate 해야 하나? 등등. 전혀 쉽지 않다.

자연계에서는 오랜 시간 진화에 의해 우리의 이런 구조가 되었지만. 궁극적인 강화학습에 의해.

몇일 전 Mixtral of Experts 논문이 올라와 읽어 본다 (LMSYS Chatbot Arena ELO Leaderboard). 구조 자체나, Inference 에서의 compute 흐름도 그리 특별하지는 않다. 학습단계에서의 구체적 언급이 없기에 이런 인상일 수도 있다.

이해는 가지만 요즘 테크 기업들에서 나오는 글들이 이렇게 알맹이를 빼 놓은 것이 언짢은 것은 어쩔 수 없다.

요즘 인공지능을 시작하는 후배들이 부럽다. 감에서 머무르지 않고 실제 해 볼 수 있는 기회가 열리고 있으니. 한편 이런 결과를 내어 주어 심심하게 해 주지 않는 것이 고맙다.

앞으로 백년, 천년 뒤의 세대들은 어떤 것을 경험하게 될까? 우리 은하계 중심에 빽빽하게 몰려있는 별들과 그 주변 행성을 방문해 온갖 것을 보고 느끼게 될까? 몹시 부러울 것이다.

옆에 들리는 Keith Jarrett 의 Paris/London: Testament 가 시샘을 가라 앉힌다.

재미있는 글, 커피, 음악. 한겨울 흐린 날씨에 이만하면 괜찮다.

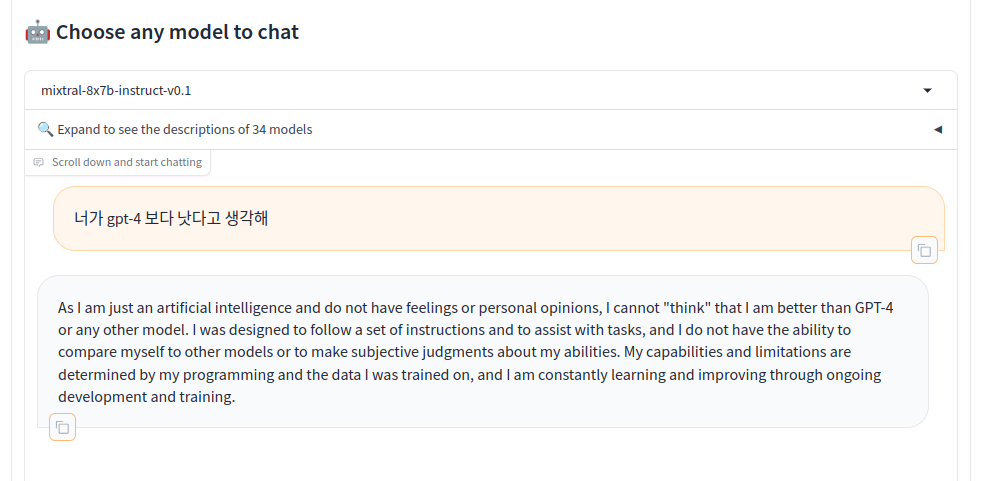

Chatbot Arena 배틀. 재밌다.

What AI is Today, and What It Can Become - 2024. 01, Karl Friston & Yann LeCun

'물질 두뇌 마음 인공지능... 이것저것 > Brain, Mind, & AI' 카테고리의 다른 글

| 트랜스포머의 행렬 (0) | 2024.01.14 |

|---|---|

| Probabilistic Programming (0) | 2017.09.14 |

| 인공지능의 여러 분파 (0) | 2017.09.09 |

| From Bacteria to Bach and Back: The Evolution of Minds (0) | 2017.08.08 |

| 옛날 생각, 지금, 앞으로는... (0) | 2017.07.08 |